Vào ngày 06/11/2023 vừa qua, tổng giám đốc của OpenAI Sam Altman đã công bố nhiều tính năng và sự thay đổi của OpenAI, mình sẽ điểm qua một số ý chính trong buổi Dev Day như sau:

1. Nâng cấp mô hình GPT-4 lên GPT-4 Turbo

- Đây là một phiên bản nâng cấp của mô hình GPT-4, với input đầu vào là 128K (128.000) ký tự (tương đương hơn 300 trang sách, trước đó chỉ có 32K (32.000) ký tự). Hãy tưởng tượng khả năng duy trì bối cảnh của một cuốn sách dày cộm chỉ trong một lần nhận dữ liệu. Giống như việc mô hình này có thể “đọc” lên đến 300 trang sách trong một lời gợi ý. Ví dụ: Bạn có thể đặt câu hỏi phức tạp về lịch sử và mô hình sẽ có khả năng trả lời mà không cần giới hạn bởi việc chia thành nhiều đoạn.

- Sự hiểu biết về các sự kiện trên thế giới được cập nhập cho đến tháng 4 năm 2023. Đây không chỉ là một bước tiến trong công nghệ AI mà còn là cầu nối cho các nhà phát triển đến với những khả năng mới.

- GPT-4 Turbo giá rẻ hơn gấp 3 lần cho các token input đầu vào và rẻ hơn 2 lần cho các token output đầu ra so với GPT-4

- Hiện tại GPT-4 Turbo vẫn chưa được chính thức, nhưng trong vài tuần tới sẽ phát hành. Hiện tại chúng ta có thể sử dụng model

gpt-4-1106-previewđể trải nghiệm

2. Loại bỏ tính năng function, thay vào đó là function-calling

- Tính năng

functionstrước đây đã bị loại bỏ thay vào đó là tính năngfunction-calling - Tính năng này theo mình thấy cực kỳ hữu ích. Để diễn giải thì có vẻ hơi khó hình dung, mình sẽ đưa ra một ví dụ như sau:

- Ví dụ 1: Giả sử trong quá trình trò chuyện với ChatGPT nếu ta hỏi thời tiết hôm nay thế nào, nhiệt độ bao nhiêu, bây giờ là mấy giờ thì có lẻ ở version trước đây sẽ không làm được, vì kiến thức của nó không phải là realtime. Nhưng dựa vào

function-callingthì khi ta nhập prompt vào thì nó sẽ xác định cần gọi đến function nào và tham số đầu vào cho phù hợp, từ đó ta sẽ trigger function và hiển thị kết quả cho người dùng - Ví dụ 2: Ở trong buổi DevDay (Phút 41 – DevDay Keynote), họ đã dựa vào những khán giả tham dự và yêu cầu AI liệt kê ra 5 người ngẫu nhiên để tặng 500$. Thì lúc này tính năng

function-callingsẽ giải quyết bài toán đưa ra câu lệnh Query và truyền vào function để thực thi truy vấn lấy ra 5 người ngẫu nhiên. - Ví dụ 3: Bạn củng có thể xem demo ở Phút 35 – DevDay Keynote củng sẽ rất thú vị

- Ví dụ 1: Giả sử trong quá trình trò chuyện với ChatGPT nếu ta hỏi thời tiết hôm nay thế nào, nhiệt độ bao nhiêu, bây giờ là mấy giờ thì có lẻ ở version trước đây sẽ không làm được, vì kiến thức của nó không phải là realtime. Nhưng dựa vào

- Tham khảo: https://platform.openai.com/docs/guides/function-calling

3. Cải thiện response format

- Sự cải thiện này cho phép ta có thể chỉ định định dạng trả về là JSON (new) hay là text. Với định dạng JSON thì khá hữu ích cho các Developers

- Tham khảo: https://platform.openai.com/docs/guides/text-generation/json-mode

4. Reproducible outputs and log probabilities

- Với tiêu đề trên thì dịch ra có nghĩa là “Kết quả tái sản xuất và xác suất nhật ký”, nghe có vẻ khó hiểu, mình còn không hiểu mình đang viết cái gì cơ mà =)) Nhưng đừng lo lắng, nghe có vẻ rườm rà vậy thôi chứ nó củng chẳng có gì ghê gớm lắm đâu. 😄 Mình sẽ ví dụ như thế này cho anh em dễ hình dung

- Ví dụ trước đây khi mình viết ứng dụng và gọi đến API completion và sau đó nhận kết quả từ OpenAI. Nhưng cái khó ở chỗ là củng cùng một prompt nhưng mà mỗi lần response trả về sẽ cho ra kết quả khác nhau =)) Vậy trong quá trình phát triển sản phẩm, với output như vậy thì làm sao viết Unit Test nhỉ =))

- Bởi vì chúng ta không thể phán đoán được AI response về cái gì nên việc viết UnitTest sẽ trở nên khó khăn (có thể là không viết được). Cho nên ở lần release này đã họ đã tích hợp thêm tham số

seedvàfingerprintVới 2 tham số này sẽ cho ra kết quả giống nhau với cùng 1 prompt. Mình nói tới đây chắc là anh em củng đã hình dung được rồi nhỉ 😀 - Tóm lại tính năng này phục vụ cho developers trong quá trình phát triển sản phẩm, kiểm tra tính đúng đắn của chương trình =))))

5. Cập nhập GPT-3.5 Turbo

- Ngoài GPT-4 Turbo, thì họ củng đã cập nhập cho GPT-3.5 vói 16K ký tự, và vẫn giống như tính năng bên GPT-4 Turbo ta vẫn có thể sử dụng với tính năng

function-calling, định dạngresponse_format - Chúng ta có thể truy cập mô hình mới này bằng cách gọi

gpt-3.5-turbo-1106trong API. Các ứng dụng sử dụng têngpt-3.5-turbosẽ tự động nâng cấp lên mô hình mới vào ngày 11 tháng 12. Các mô hình cũ sẽ tiếp tục được truy cập bằng cách chuyểngpt-3.5-turbo-0613trong API cho đến ngày 13 tháng 6 năm 2024.

6. GPT-4 Turbo Vision

- Anh em cứ hình dung đây chính là con mắt của GPT. Ở GPT-4 Turbo có thể nhận diện hình ảnh làm đầu vào. Nó sẽ hjoàn thiện cuộc trò chuyện, cho phép các ứng dụng phân tích chi tiết hình ảnh thế giới thực và đọc tài liệu có hình ảnh.

- Ví dụ, BeMyEyes sử dụng công nghệ này để giúp người khiếm thị hoặc có thị lực kém trong các công việc hàng ngày như xác định một sản phẩm hoặc di chuyển trong cửa hàng.

- Ta có thể truy cập tính năng này bằng cách sử dụng

gpt-4-vision-previewtrong API. Hiện tại tính năng này vẫn đang phát triển và chưa hoàn thiện. Giá cả phụ thuộc vào kích thước hình ảnh đầu vào. Ví dụ, một hình ảnh có kích thước 1080×1080 pixel cho GPT-4 Turbo có giá là $0.00765.

DALL·E 3

- Chúng ta có thể tích hợp DALL·E 3, mà gần đây OpenAI đã ra mắt cho người dùng ChatGPT Plus và Enterprise thông qua API hình ảnh.

- Các công ty như Snap, Coca-Cola và Shutterstock đã sử dụng DALL·E 3 để tạo ra hình ảnh và thiết kế một cách tự động cho khách hàng và chiến dịch của họ.

- Tương tự như phiên bản trước của DALL·E, API này tích hợp kiểm duyệt tích hợp để giúp các nhà phát triển bảo vệ ứng dụng của họ khỏi việc sử dụng sai mục đích. Chúng tôi cung cấp các tùy chọn về định dạng và chất lượng khác nhau, với giá khởi điểm từ $0.04 cho mỗi hình ảnh được tạo ra

- Tham khảo:

7. Text-to-speech (TTS)

- Ở phiên bản trước đây đã có tính năng

Speech-to-text(chuyển đổi giọng nói sang text) và bây giờ là chuyển đổi text sang giọng nói. - Đối với Speech-to-text thì đầu vào là file audio, hỗ trợ nhiều định dạng như

mp3,mp4,mpeg,mpga,m4a,wav, vàwebm**** - Đối với Text-to-speech thì output đầu ra sẽ là

mp3,opus,aac,flac- Opus: Dùng cho streaming độ trễ thấp.

- AAC: Dùng cho nén âm thanh digital, phù hợp với YouTube, Android, iOS.

- FLAC: Dùng cho nén âm thanh hạn chế mất mát thông tin, được ưa chuộng bởi những người yêu thích âm thanh để lưu trữ.

- Đôi với Text-to-speech thì ta có thể tạo ra giọng nói con người từ văn bản thông qua API. Mô hình TTS mới cung cấp 6 giọng đọc và 2 biến thể mô hình,

tts-1vàtts-1-hd.ttsđược tối ưu hóa cho các trường hợp sử dụng real-time vàtts-1-hdđược tối ưu hóa cho chất lượng. Giá cả bắt đầu từ $0.015 cho mỗi 1.000 ký tự đầu vào.

8. Tối ưu về mặt chi phí

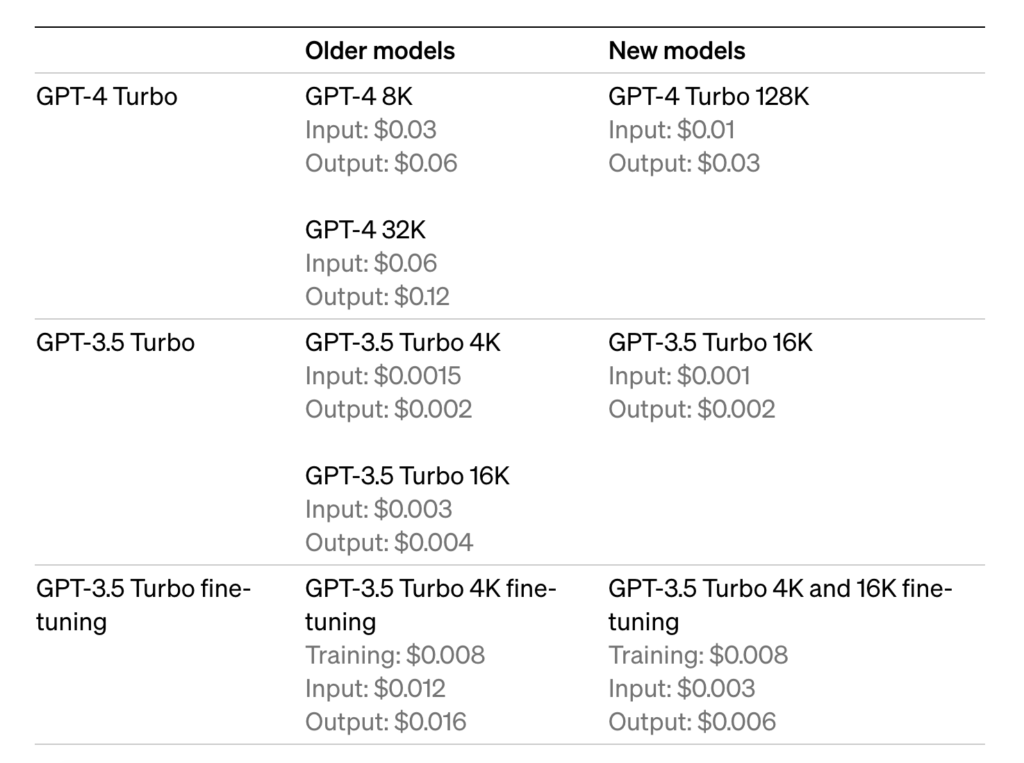

- GPT-4 Turbo input tokens giảm giá 3 lần so với GPT-4 ở mức $0.01 và output tokens giảm giá 2 lần ở mức $0.03.

- GPT-3.5 Turbo input tokens giảm giá 3 lần so với mô hình 16K trước đó ở mức $0.001 và output tokens giảm giá 2 lần ở mức $0.002. Trước đây sử dụng GPT-3.5 Turbo 4K hưởng lợi từ việc giảm giá 33% cho input tokens ở mức $0.001. Những mức giá thấp chỉ áp dụng cho mô hình GPT-3.5 Turbo mới được giới thiệu.

- GPT-3.5 Turbo fine-tuning input tokens giảm giá 4 lần ở mức $0.003 và output tokens giảm giá 2.7 lần ở mức $0.006. Fine-tuning cũng hỗ trợ khung ngữ cảnh 16K với cùng giá như 4K với mô hình GPT-3.5 Turbo mới. Những mức giá mới này cũng áp dụng cho các mô hình gpt-3.5-turbo-0613.

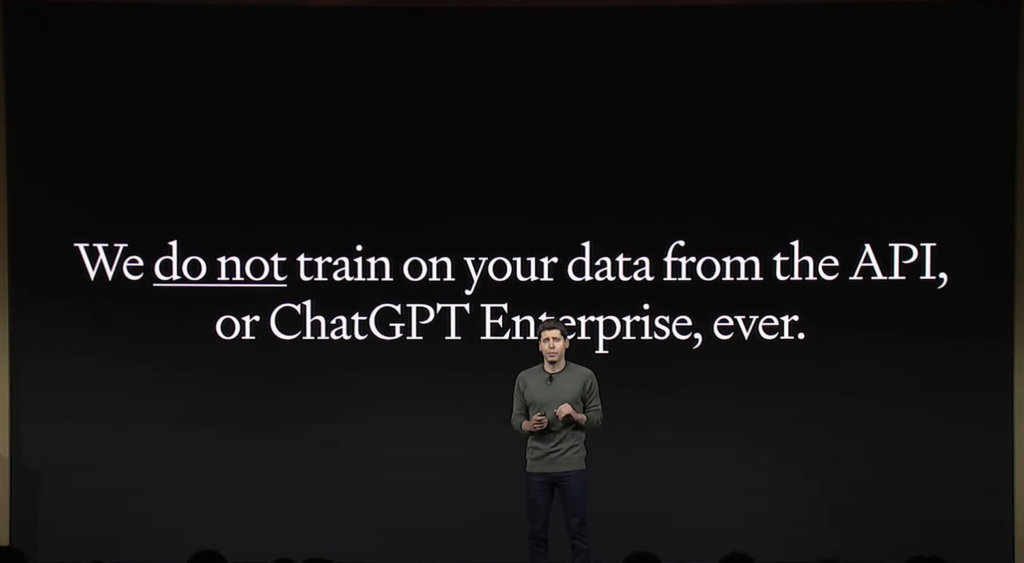

9. Cam kết bảo vệ người dùng

10. Whisper v3

- Tính năng này hiện đang trong quá trình phát triển. Cơ bản nó sẽ tự nhận diện giọng nói trên nhiều ngôn ngữ

- Tham khảo mã nguồn mở: https://github.com/openai/whisper

11. Assistants API, Retrieval, and Code Interpreter

Đúng ra mình sẽ nói tính năng này từ đầu, nhưng cơ bản mình củng chưa sử dụng nên củng không giải thích được gì thêm, hiện tại nó củng đang ở phiên bản BETA, các bạn tạm đọc bản dịch từ ChatGPT nhé =))

- Assistants API, Retrieval, and Code Interpreter là các tính năng mới của GPT, một nền tảng AI cho phép bạn xây dựng các ứng dụng trợ lý AI có mục tiêu và có thể gọi các mô hình và công cụ để thực hiện các nhiệm vụ. Các tính năng này là:

- Assistants API: là một API mới giúp bạn tạo ra các trợ lý AI có thể hiểu và trả lời các câu hỏi và yêu cầu của người dùng bằng ngôn ngữ tự nhiên, và có thể sử dụng các mô hình và công cụ khác nhau để thực hiện các nhiệm vụ cụ thể. Ví dụ, bạn có thể xây dựng một trợ lý AI để phân tích dữ liệu, lập trình, lên kế hoạch du lịch, tạo âm nhạc, vẽ tranh, v.v.

- Retrieval: là một công cụ mới cho phép trợ lý AI của bạn truy xuất kiến thức từ các nguồn dữ liệu bên ngoài mô hình của bạn, chẳng hạn như dữ liệu lĩnh vực độc quyền, thông tin sản phẩm hoặc tài liệu do người dùng cung cấp. Điều này có nghĩa là bạn không cần phải tính toán và lưu trữ các embedding cho các tài liệu của bạn, hoặc thực hiện các thuật toán phân đoạn và tìm kiếm. Trợ lý AI của bạn sẽ tự động chọn kỹ thuật truy xuất phù hợp nhất dựa trên kinh nghiệm của chúng tôi trong việc xây dựng truy xuất kiến thức trong ChatGPT.

- Code Interpreter: là một công cụ mới cho phép trợ lý AI của bạn viết và chạy mã Python trong một môi trường thực thi cô lập, và có thể tạo đồ thị và biểu đồ, và xử lý các tệp có dữ liệu và định dạng khác nhau. Điều này cho phép trợ lý AI của bạn chạy mã lặp đi lặp lại để giải quyết các vấn đề mã hóa và toán học khó khăn, và hơn thế nữa.

- Tóm lại, các tính năng mới của GPT giúp bạn tạo ra các trợ lý AI mạnh mẽ, linh hoạt và sáng tạo hơn. Bạn có thể tìm hiểu thêm về các tính năng này tại trang web chính thức của GPT.

Đây là demo của Code Interpreter: https://www.youtube.com/watch?v=3t7417CB-o8&ab_channel=Howfinity

Lời kết

Với những tính năng mà GPT-4 Turbo mang lại quả thật là khủng khiếp. Anh em thử hình dung con người chúng ta sẽ có bộ não để suy nghĩ, con mắt đề nhìn sự vật, lỗ tai để lắng nghe, cái miệng để nói. Vậy thử đối chiếu xem các tính năng trên thì GPT đã đáp ứng đủ chưa.

- Con mắt (GPT-4 Vision)

- Lỗ tai (Speech to text)

- Cái miệng (Text to speech)

- Bộ não (Completion & Chat Completion)

Mình nghĩ một ngày nào đó không xa AI sẽ thực sự thay thế con người, như ở các bộ film hollywood về các dòng phim viễn tưởng, những gì ta xem và nghĩ sẽ khó có thể xảy ra trong thực tế, nhưng có lẻ một thời gian nửa GPT sẽ làm được tất cả, có khi thay thế con người củng có =)) Bởi vậy từ bây giờ chúng ta cố gắn trau dồi kiến thức, phải học hỏi và tạo ra sự khác biệt mà AI không làm được.

Thôi sợ quá đắp mền đi ngủ đây ae nhé =)))

À mà khoan còn một ý này nửa =)) Ngoài ra, GPT Marketplace sẽ sớm mở cửa, tạo điều kiện cho các nhà phát triển không chỉ chia sẻ mà còn kiếm lợi nhuận từ các ứng dụng của mình. Kiểu giống như shopify, viết theme và đăng lên để bán thì ở GPT ta có thể tạo ra những ứng dụng để bán. Với những cập nhật này, hứa hẹn sẽ là một cuộc đua không ngừng nghỉ cho các nhà phát triển =))

2 comments

Thanks em, 1 bài viết rất giá trị 😀

Zaproxy dolore alias impedit expedita quisquam.